El Google I/O 2025 ya está aquí. Todas las novedades de Google están totalmente enfocadas en las capacidades de la inteligencia artificial dentro de los distintos productos de Google, para así tener un poco de todo: desde mejores capacidades para Gemini, con todo y su integración como asistente, nuevos modelos para generación de contenido multimedia y código.

Además hay otras novedades como la llegada del modo de IA al buscador, anunciado como prueba recientemente; la expansión de los AI Overviews a más países; nuevas funciones como la posibilidad de probarse ropa virtualmente con IA, nuevos planes de suscripción para los modelos más potentes de Google, funciones mejoradas de comunicación en videollamadas con traducción instantánea, y la integración de Android XR, con todo y Gemini, en lentes inteligentes y audífonos.

Mejoras para Gemini

Empecemos por Gemini. Google indica que todos sus modelos 2.5 se han actualizado, lo que significa que ahora se desempeñan mejor que nunca y hasta tienen mayores capacidades.

Todos los modelos de Gemini 2.5 ahora cuentan con salidas nativas de audio y soporte para permitir a los usuarios variar el tono, acento y estilo de habla de la IA, por ejemplo, pedirle que use una "voz dramática cuando cuenta una historia".

De la mano de esta nueva versión de Gemini 2.5 llegan novedades como “Diálogo afectivo”, donde el modelo detecta las emociones en la voz del usuario y responde en consecuencia; o “Audio proactivo”, que ignora conversaciones previas y sabe exactamente cuándo responder. Además, soporta hasta dos voces con las cuales puede interactuar.

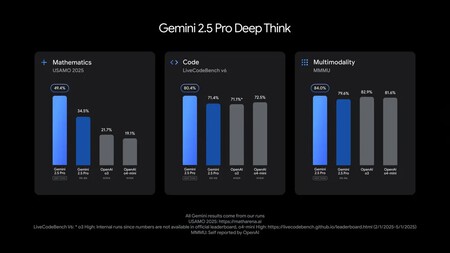

El rendimiento de "Deep Think" de Gemini respecto a otras IA en el mercado.

El rendimiento de "Deep Think" de Gemini respecto a otras IA en el mercado.

En el caso de Gemini 2.5 Flash, ahora es más potente y eficiente, además de ser más rápido, con mejoras en indicadores de razonamiento, multimodalidad, código y ventanas de contexto amplias que usan entre 20 y 30% menos tokens. Ya está disponible no solo para los usuarios de la app de Gemini, sino también en Google AI Studio y Vertex AI para empresas.

Mientras tanto, Gemini 2.5 Pro ahora destaca por sus capacidades para la codificación, además de ser el modelo más potente para tareas de aprendizaje.

Gemini más integrado y accesible

Más sobre Gemini. La IA de Google ahora también es más personal, proactiva y potente, con capacidades como que en su app para iOS y Android ahora se podrá compartir la cámara y la pantalla en Gemini Live, gratis para todos. Próximamente, también será posible crear eventos en el Calendario con la IA, además de obtener detalles desde Maps, tareas o notas gracias a nuevas integraciones.

Como parte de sus funciones de asistente, llegan también mejoras a Deep Research, su búsqueda profunda, que ahora permite añadir fuentes propias a una investigación. Con Canvas, será posible crear elementos y contenido alrededor de cualquier material proporcionado, entre ellos una especie de podcast con IA, como si se tratara de la capacidad de NotebookLM, además de tener la posibilidad de generar cuestionarios interactivos desde Gemini, y con "Contexto Personal", ahora Gemini tendrá la capacidad de recordar búsquedas y afinar resultados al historial de consultas de cada usuario.

De la mano de todas estas mejoras, ahora hay nuevos planes para las versiones más potentes de la IA: Google AI Pro y Google AI Ultra (por 19.99 y 249.99 dólares respectivamente), que permiten acceso a funciones adicionales, límites más altos de procesamiento y acceso anticipado a herramientas complementarias.

Además, ahora Gemini no estará disponible solamente en su propia aplicación o en la web. Google comenzará a integrarla directamente en Chrome, aunque esta función llegará primero para los suscriptores de los planes Pro y Ultra en Estados Unidos, en inglés, para Windows y Mac. En el futuro, será posible interactuar con pestañas y navegar por sitios web, aunque de momento solo funciona para explicar información que se ve en internet.

Generación de contenido multimedia: Veo 3, Imagen 4 y Flow

En el área de inteligencia artificial, no podían faltar las herramientas Veo 3 e Imagen 4, sus modelos para la creación de video e imágenes generativas, además de una nueva herramienta llamada Flow.

Con Veo 3 llega la posibilidad de generar video y también audio contextual, como ruido de tráfico en una ciudad, aves cantando en un parque o incluso diálogos entre personajes. También mejora las físicas realistas y la sincronización de labios, todo a partir de un prompt. Veo 3 está disponible por ahora únicamente para suscriptores de Ultra en EE. UU., en la app y en Flow.

Por su parte, Imagen 4 es el modelo para creación de imágenes, ahora con mayor velocidad de respuesta y precisión, especialmente en detalles como materiales, gotas de agua o pelaje de animales. Se destaca tanto en contenido fotorrealista como en estilos abstractos, con capacidad para generar imágenes en resoluciones de hasta 2K, listas para impresión o presentaciones. También están optimizados en ortografía y tipografía, lo que permite crear fácilmente desde cartas hasta cómics.

En los elementos multimedia también se suma Flow, una nueva herramienta de IA para cine, diseñada para trabajar con Veo. Permite crear clips cinematográficos, escenas e historias con control total de cámara, locaciones, personajes, objetos y estilos, todo a partir de lenguaje natural. Está disponible por ahora solo para usuarios de Google AI Pro y Ultra, únicamente en Estados Unidos.

Por último, llega Lyria 2, basada en Music AI Sandbox, pensada para músicos, productores y compositores, que les permite explorar nuevas ideas musicales. Está disponible para YouTube Shorts o como herramienta independiente en Lyria RealTime, enfocada en generación de música con IA.

Para poder manejar todo este contenido generado por inteligencia artificial, Google también ha desarrollado un nuevo detector de contenido generado por IA, llamado SynthID Detector, con el que busca reducir la desinformación o las atribuciones erróneas de autoría.

Búsqueda con IA más profunda y personalizada

Pasemos al apartado de búsquedas. Para empezar, Google anunció que su función AI Overviews, diseñada para responder preguntas directas al inicio de una búsqueda (sin necesidad de entrar a un sitio web), se expandirá a más de 200 países y 40 idiomas. Esta función, lanzada en 2024 y ya disponible en México, permite obtener resúmenes generados por IA como primer resultado de consulta.

También llega oficialmente el AI Mode, aunque por ahora solo en Estados Unidos. Se trata de una herramienta que combina razonamiento avanzado y capacidades multimodales para dar seguimiento a preguntas y mostrar enlaces útiles. Este modo estará disponible a través de un botón en la barra de búsqueda y en la página principal de Google.

Esto permitirá que, ante preguntas directas, la IA pueda iniciar la búsqueda de contenido de forma más profunda que con el método tradicional, para encontrar resultados más útiles. Se podrá combinar con herramientas como Deep Search, Live (derivado del proyecto Astra), o búsquedas en tiempo real con la cámara del dispositivo.

Además, será posible realizar acciones como comprar boletos o buscar productos con base en el contexto personal del usuario, y visualizar mejor los datos a través de tablas y gráficas generadas automáticamente por la IA.

Compras asistidas por IA y probadores virtuales

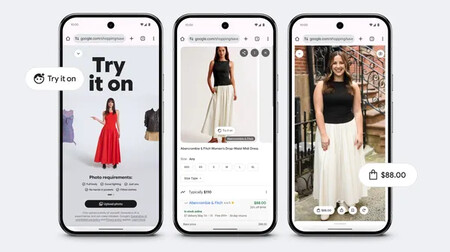

Otra de las novedades que Google presentó con IA es la capacidad de comprar con AI Mode, una herramienta que permite explorar productos, obtener recomendaciones y hasta probarse ropa de forma virtual, todo desde la experiencia de búsqueda. Esto es posible gracias a su catálogo de más de 50 mil millones de productos listados, que incluye reseñas, precios, colores disponibles y opciones de seguimiento de precio para adquirir artículos en el mejor momento.

En particular, la nueva función de probador virtual permite ver cómo luciría una prenda sobre el cuerpo del usuario antes de comprar en línea. Utiliza tecnología de escalado inteligente que ajusta cada prenda según las dimensiones corporales del comprador, a partir de fotografías en distintas poses, lo que mejora la precisión del ajuste.

Por ahora, esta función está disponible únicamente en Estados Unidos, y permite probar prendas como playeras, pantalones, faldas o vestidos mediante un nuevo botón de “Probarse” visible en el listado de productos compatibles.

Más IA en Gmail, Meet, Docs y Vids

Hay otras implementaciones importantes, como Gemini en Workspace, que amplía las capacidades de la IA a herramientas como Gmail, Meet, Vids y Docs, para ayudar a los usuarios a responder más rápido correos, comunicarse en varios idiomas, generar videos o escribir con fuentes relevantes.

En el caso de Gmail, además de las respuestas inteligentes personalizadas, ahora Gemini puede ayudar a organizar la bandeja de entrada. Por ejemplo, es posible pedirle que elimine correos innecesarios provenientes de una dirección específica o que agende reuniones directamente, sin salir del correo.

También llega la función de traducción en tiempo real en Google Meet, que ofrece baja latencia y mantiene la voz, el tono y las expresiones del hablante original, con el objetivo de sostener una conversación “auténtica y natural”. Esta función estará disponible inicialmente para suscriptores de Google AI Pro y Ultra, en beta, comenzando con inglés y español, aunque más idiomas y una versión para negocios llegarán en las próximas semanas.

Además, Google Vids introduce la posibilidad de transformar presentaciones en videos de forma automática. Entre sus capacidades destacan la eliminación de muletillas como “eh” y “um” en grabaciones, la mejora automática del audio, la generación de transcripciones y la opción de utilizar avatares de IA que pueden entregar un mensaje optimizado para cierto tipo de audiencia.

Videollamadas 3D: así es Google Beam

En el tema de videollamadas en 3D, Google presentó la evolución de su iniciativa conocida como Project Starline, que buscaba permitir conversaciones remotas que se sintieran como si las personas estuvieran en la misma habitación, sin necesidad de lentes especiales ni visores.

Ahora, este proyecto ha sido renombrado como Google Beam, una plataforma de videollamadas que, según la compañía, es la primera en ofrecer video 3D con modelos volumétricos generados con IA. Esto permite que las personas se vean en tres dimensiones desde cualquier ángulo, gracias a una combinación de inteligencia artificial y múltiples cámaras que capturan imágenes desde diferentes perspectivas, lo que genera una fuerte sensación de profundidad y realismo.

Google también planea integrar en Beam funciones como la traducción simultánea de idiomas de Google Meet, y ha anunciado que este producto llegará al mercado en 2025 en alianza con HP, además de que ya se trabaja con otras plataformas como Zoom para integrarlo en entornos organizacionales.

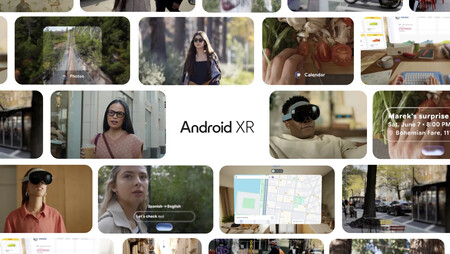

Gemini también llega a Android XR, lentes y más dispositivos

Por último, Google mostró también sus avances en Android XR, con el objetivo de llevar la inteligencia artificial de Gemini a prácticamente todas las plataformas posibles, incluyendo smartphones, televisores y pantallas dentro de vehículos, con la intención de consolidarlo como un verdadero asistente inteligente omnipresente.

Entre los productos destacados está Project Moohan, una colaboración con Samsung para desarrollar un visor XR con Gemini integrado, que ofrece una experiencia inmersiva centrada en IA. Además, Google también mostró una especie de evolución de Google Glass, que integra a Gemini en lentes inteligentes capaces de interactuar en múltiples entornos y situaciones cotidianas, con comandos y respuestas contextuales directamente desde la montura.